此文为大体量之下篇,大体量之上篇见此

偌大的数据都在哪里?——大数据创业者的寻宝图

大数据荡漾了无数创业者和技术男的春心。而它作为一个典型的2B市场,创业者们面对的是什么样的B呢?哪些行业会拥有大数据呢?大数据通常分为四类:科研数据,互联网数据,企业数据,和感知数据。

科研数据属于大数据时代前很久就存在的史前生物,可能来自生物工程、天文望远镜或粒子对撞机,不一而足。这些数据存在于封闭系统中,玩家都是传统上做高性能计算(HPC)的企业,这里不再展开。值得一提的是,常常听到这些企业愤愤不平地说很多大数据技术是他们发明的,大数据只是某些人创造和炒作的新概念。公允地讲,很多大数据技术脱胎于HPC不假。只是这些老兄也未必纯洁。早在大数据作为一个新概念出现之前,他们就开始炒一个概念,Data Intensive Scalable Computing (DISC)。DISC挟数据库老法师JimGray(彼时Jim公在微软研究院做天文数据处理的研究)第四范式(The Fourth Paradigm)之名,居高临下却未能君临天下。有很多原因,如DISC没有Big Data响亮,Jim公离奇海上失踪,等等。但在下认为最主要的原因还是格局小了,只盯着高富帅的科研数据,而忽略了大众市场。

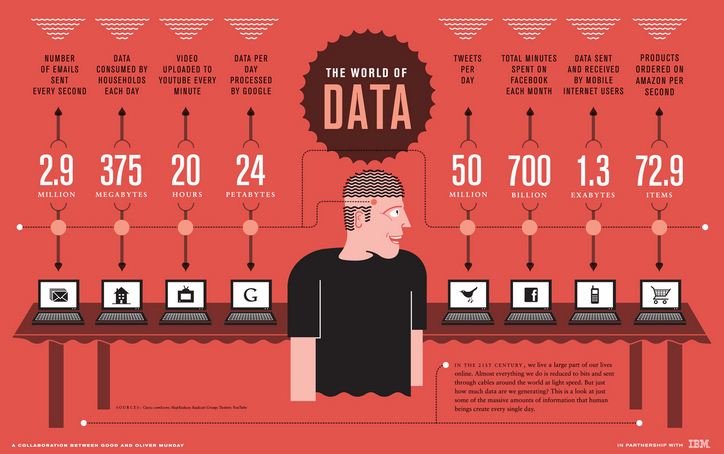

互联网大数据是目前这个时代的主流,尤其社交媒体被认为是大数据的爆发点。几乎所有的大数据技术都起源于互联网企业。所有这些企业当中,做搜索的最大,不说谷歌,百度也达到了千PB的规模。Facebook、Yahoo等都在数百PB,Amazon、阿里应该也同在此列。互联网数据增长的驱动力一是梅特卡夫定律(互联网企业的价值与用户数的平方成正比),二是扎克伯格反复引用的信息分享理论:一个人分享的信息每一到两年翻番。

大型互联网企业的大数据生态系统也比较独特,一方面不同程度上参与开源,一方面维护自给自足的生态系统,甚至连硬件都越来越依靠自己了:从谷歌开始,后有Facebook的Open Compute Project,国内有TAB主导的天蝎计划。大型互联网公司不只是自身产生大体量数据,它还有平台级的带动作用,如Facebook之于Zynga。阿里牵头做数据交换平台也是件好事。

对于中型互联网公司来说,基本上也能够维持大数据技术团队,只不过与大型互联网公司的核心开发能力和社区贡献能力相比,他们更多部重兵在外围开发、优化和运维。当然,他们多少会有一些绝招,比如豆瓣的推荐,暴风的Hadoop管理。

三线互联网公司有数据但没有大数据能力,这催生了一些大数据技术和服务的机会,如百分点为电商网站做个性化推荐和营销分析,各类广告联盟、移动应用服务平台为网站和移动应用提供统计分析、营销服务等。

进入移动互联网时代后,移动平台的感知功能和LBS的普及,使得互联网数据与感知数据产生了重叠。同样,企业数据和感知数据本质上也并不是所谓MECE(不重复、不遗漏)的划分,如企业会部署物联网收集感知数据。之所以把它们分为两类,是传统上认为企业数据是人产生的,感知数据是物、传感器、标识等机器产生的。感知数据的体量要大得多,Teradata预测感知数据的总量在2015年超过社交媒体,并达到后者的10-20倍。重庆平安城市项目在薄王出事前规划了50万摄像头,数据存储需求要达到百PB级别,不亚于世界级的互联网公司。相比而言,企业的数据比起十年前并没有数量级的提升,只不过在传统结构化数据的基础上加入了非结构化数据的内容。

把企业数据和感知数据放在一起讲是因为它们都涉及传统产业,从经济总量上要比互联网产业大很多,而且传统产业自身的大数据能力有限,所以这是大数据技术和服务企业的主要目标市场。但目前骨感的现实是就单个企业而言,具有大数据需求的并不多见。比如说麦肯锡的报告中把制造业列为大数据存量最多的行业,但很少听到制造企业上马大数据项目。即使有,如Zara,只是在市场营销上加入了互联网的招数,来自终端的需求获得这块有点意思,供应链和生产这块相比大数据之前没有太多新意。通过数据采集和分析来提升制造业的效率,会是个很大的市场,这是工业物联网,但未必是大数据。

从行业上讲,拥有大数据的主要在公共管理和服务、电信、金融、医疗和零售等方面。但啃这些客户都不是易事:

(1) 公共管理和服务领域最高可以达到百PB级,但金主是政府,能让他们看得上眼的没几家,而且BOT不好玩。

(2) 电信和金融可以达到数十PB级,但客大欺店,而且自身IT能力较强。

(3) 医疗的瓶颈在跨医院的数据整合,这块目前开来只能地方牵头做,但地方的事儿有很多裙带关系出没。

(4) 零售业内有大数据的一定是连锁,多数成本压力大,议价能力强,赚他们的钱不容易。

从赚钱机会上来看,大数据还没到“满地是沙子、满地是金子”的时候。对于大数据技术和服务公司而言,三线互联网公司是现成的机会。而最大的蛋糕——企业数据和感知数据,目前只是闻到香味而已。好在竞争还不激烈,海外的高富帅(IBM、EMC、Microsoft等)太高太贵,平民产品(Cloudera的CDH、Hortonworks的HDP和Intel的IDH Hadoop发行版)还在学习市场,国内的互联网大佬们似乎还未觊觎这块蛋糕(阿里是最有可能先跨界伸手的),华为还戴着《基本法》的镣铐徘徊在信息服务业的门口,三大电信有企图但技术还不成熟。国内互联网企业将再次扮演黄埔军校,培养前仆后继的大数据创业者。

最后补充一句,即使大数据还没到大规模爆发的春天,大数据早期接纳者(early adopters)的启动还是会催生咨询服务的市场。

面临大体量数据,在思维和行动上要做什么样的准备?——业务决策者应有的大数据观

每每开会谈大数据,似乎不是Hadoop就是NoSQL数据库。究其原因,主要可能还是与会人员来自互联网企业和技术第一线。其实,大数据是一种思维,一种战略,而它应该是面对用户、面向业务和应用的。业务决策者和企业IT技术人员很明显在各种大数据峰会上缺位了。好在,前面所说的两本书,就是为他们准备的。

大数据时代,需要新的世界观。大数据开启了一个新的世界,我们对这个世界的认知必须主动求变。

旧的认识是“数据是稀缺资源”,这种认识直接导致“数据小农”心态。大数据开始于数据测量,而数据小农拣着测、挑着存、采着样来处理,总是幻想能够从最少的数据压榨出最多的信息。

而新的认识是,要参与大数据的游戏并且致胜,必须产生大数据。在大数据时代,拥有大数据是一种幸福和特权。舍恩伯格在《大数据时代》里指出三大思维变革之首就是要数据全集,不要样本子集(其它两大变革以后会说到)。这个思维的基础是有全集数据。因此,每一个个体、企业和政府需要自觉、客观、全面地去测量世界,并且把数据存下来。把数据采集和保存成为一种信仰,成为一种责任。

决策者需要具备的大数据观很简单:数据不是累赘,要投资数据采集的基础设施,采完用完不要急着扔掉,把它存下来,数据里有很多价值(在以后讲Value时会详述),数据的存储和搬运会越来越便宜,IT部门可以从成本中心变成利润中心。

拣着测、挑着存、采着样处理,问题在于自我选择机制导致的低数据质量。有个老外写了本书叫《Raw data is an oxymoron》,直译是“原始数据的说法是一种矛盾修辞法”。因为数据不是自然资源,它不是“原始”的,它是带着文化背景和主观倾向的人去产生和解释的,带入了自我选择机制,从前数字时代到数字时代,无一例外。所以,必须尽量地减少主观性。第一,尽量由“机器”来决定采什么、哪里采。拿在程序里加日志为例,可以通过源代码分析工具来自动插入日志的写入点。第二,如果是答案产生的过程本身带有主观性(如民意调查),那数据采集可能需要设计成多变量(如通过问很多问题)来约束主观误差。第三,尽量把数据采集和存储纳入基础框架,而不是来一个业务做一种采集/存储方案。

采样处理还有个问题,基于随机采样的方法可以使数据反映常态现象(个位数百分点的误差),但容易遗漏个案的异常。由于现在经济中的“黑天鹅现象”往往是个案异常,采样方法可能摊上大事。

子沛在《大数据》里讲到政府采集数据时的减负原则很重要。一旦数据采集是种负担,它的完整性和真实性都会产生瑕疵。纯软件的数据采集还好,如果需要人力物力,决策者要适当引入激励机制。

当然,在采集到大数据以后,决策者需要做的事就更多了,涉及人、文化、组织和流程等诸方面。因为今天就讲大体量,这些以后再表。如果看官着急,不妨把出自Teradata的《驾驭大数据》找来看看。

舍恩伯格在他的另一本书《删除》中表达了数字化时代要学会遗忘(digital forgetting)的观点,讲述了数据太多的烦恼和风险。这与全集思维并不矛盾。大数据的低信息密度和高冗余度不排除采取删除(如去冗余)的手段,在很多场合下还需要匿名化(anonymization)、混淆(obfuscation)和过滤(filtering),但实施这些手段的前提是保留数据全集的完整性和分析价值。

大数据大体量,对于业界巨擘、创业者和业务决策者,不同的人有不同的理解,今天暂且侃到这儿。下一篇聊大数据的多样性和混杂性(Variety)。

预告一下未来系列内容:

(1) 多样性和混杂性(Variety)

(2) 快速化(Velocity)

(3) 真实性(Veracity)

(4) 大价值(Value)

(5) 相关性和因果性

(6) 数据权利

(7) 数据分析

(8) 企业IT人员的简易手册

(9) …

做人要厚道,转载请注明文章来源:

https://www.boxui.com/ued/design-idea/4130.html

评论回复